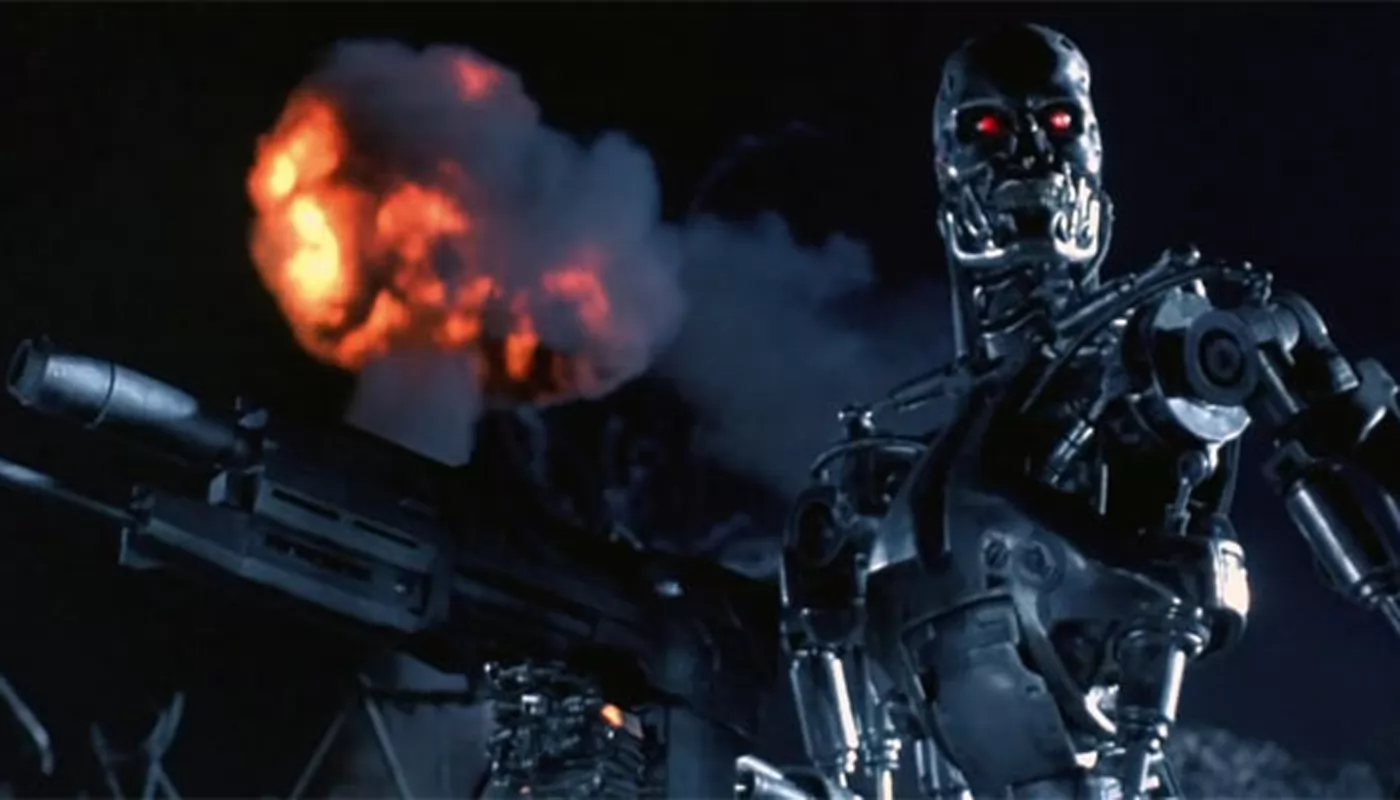

Режиссер «Терминатора» определил три угрозы для человечества

Хотя Джеймс Кэмерон признает полезность искусственного интеллекта в кинопроизводстве, создатель «Терминатора» убежден, что сочетание ИИ и гонки вооружений представляет собой опасность, и события из его фильмов могут стать реальными, если искусственный интеллект окажется в ненадежных руках.

«Я не сомневаюсь в угрозе апокалиптического сценария, подобного «Терминатору», если произойдет интеграция искусственного интеллекта с системами вооружения, включая системы ядерного оружия и обороны, контрударные системы и другие подобные технологии, — выразил свои тревоги Джеймс Кэмерон в одном из интервью, обсуждая будущую экранизацию книги «Призраки Хиросимы» Чарльза Пеллегрино. — Это очень серьезная проблема. Учитывая стремительное развитие военных технологий и сжатые временные рамки для принятия решений, потребуется сверхинтеллект для их обработки. Возможно, мы будем достаточно разумны, чтобы оставить человека в цепочке принятия решений. Однако люди не совершенны, и множество ошибок уже приводили нас к опасным международным инцидентам, которые могли бы вызвать ядерный конфликт. Поэтому я не уверен».

Джеймс Кэмерон выделил три основные угрозы для человечества в настоящее время: «изменения климата и деградация окружающей среды, ядерное оружие и сверхразум». «Есть ощущение, что все эти угрозы нарастают и достигают пика одновременно. Возможно, сверхинтеллект станет ответом. Я не знаю. Я этого не утверждаю, но, возможно, так оно и будет».